Slik optimaliseres intralogistikk for å effektivisere og øke hastigheten til forsyningskjedene i Industri 4.0 – Del to av to

Bidrag fra DigiKeys nordamerikanske redaktører

2023-09-22

Del 1 i denne serien om intralogistikk tok for seg problemstillinger knyttet til hvordan autonome mobile roboter (AMR – autonomous mobile robot) og automatiserte veiledede kjøretøy (AGV – automated guided vehicle) brukes på systemnivå til å implementere intralogistikk og raskt og sikkert flytte materialer etter behov. Denne artikkelen fokuserer på brukstilfeller og hvordan AMR-er og AGV-er bruker sensorer til å identifisere og spore elementer, hvordan maskinlæring (ML) og kunstig intelligens (AI) støtter materialidentifikasjon, bevegelse og levering av materialer gjennom hele lageret og produksjonsanlegget.

Intralogistikk (intern logistikk) bruker autonome mobile roboter (AMR-er) og automatiserte veiledede kjøretøy (AGV-er) til å effektivt flytte materialer rundt på Industri 4.0-lager og -produksjonsanlegg. For å effektivisere og øke hastigheten til forsyningskjedene, må intralogistikksystemer vite den nåværende plasseringen til materialet, den tiltenkte destinasjonen for materialet og den sikreste, mest effektive banen for å nå destinasjonen til materialet. Denne effektive navigasjonen krever et mangfold av sensorer.

I intralogistikkløsninger bruker AGV-er og AMR-er sensorer til å øke situasjonsbevisstheten. Sensormatriser gir sikkerhet for personell i nærheten, beskyttelse av annet utstyr og effektiv navigasjon og lokalisering. Avhengig av kravene til konstruksjonen, kan sensorteknologier for AMR-er inkludere kontaktsensorer som grensebrytere integrert i støtfangere, 2D- og 3D-lysdeteksjon og -avstandsmåling (LiDAR), ultralyd, 2D- og stereokameraer, radar, kodere, enheter for treghetsmåling (IMU – inertial measurement unit) og fotoceller. For AGV-er kan sensorer inkludere magnetiske, induktive eller optiske linjesensorer, samt grensebrytere integrert i støtfangere, 2D-LiDAR og kodere.

Den første artikkelen i denne serien dekker problemstillinger knyttet til hvordan AMR-er og AGV-er brukes på systemnivå til å implementere intralogistikk og effektivt flytte materialer etter behov.

Denne artikkelen fokuserer på sensorfusjon og hvordan AMR-er og AGV-er bruker kombinasjoner av sensorer i tillegg til AI og ML for lokalisering, navigasjon og driftssikkerhet. Den begynner med en kort gjennomgang av vanlige sensorer som finnes i AGV-er, undersøker robotposisjon (robot pose) og simultane lokaliserings- og kartleggingsalgoritmer ved hjelp av sensorfusjon, vurderer hvordan SLAM-estimater kan forbedres med teknikker for skanning-til-kart-samsvaring (scan-to-map matching) og skanning-til-skanning-samsvaring, og avslutter med en titt på hvordan sensorfusjon bidrar til sikker drift for AMR-er og AGV-er. DigiKey støtter konstruktører med et bredt sortiment av sensorer og brytere for robotikk og andre industrielle konstruksjoner i alle disse tilfellene.

En rekke sensorer og sensorfusjon, AI, ML og trådløs konnektivitet er nødvendig for å støtte autonom drift og sikkerhet i AMR-er. Selv om ytelseskravene for AGV-er er lavere, er de fortsatt avhengige av flere sensorer for å støtte sikker og effektiv drift. Det er to overordnede kategorier av sensorer:

- Proprioceptive sensorer måler verdier internt i roboten, slik som hjulhastighet, belastning, batterilading og så videre.

- Exteroceptive sensorer gir informasjon om robotens omgivelser, slik som avstandsmålinger, landemerkeplasseringer og identifikasjon av hindringer, for eksempel personer som trer inn i robotens bane.

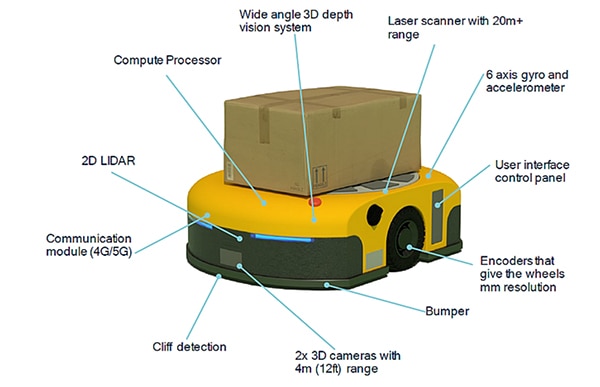

Sensorfusjon i AGV-er og AMR-er er avhengig av kombinasjoner av proprioceptive og eksteroceptive sensorer. Eksempler på sensorer i AMR-er omfatter (figur 1):

- Laserskanner for objektdeteksjon med rekkevidde på 20+ meter (m)

- IMU med et seksakset gyroskop og akselerometer, og noen ganger med et magnetometer

- Kodere med millimeter-oppløsning på hjulene

- Kontaktsensor, for eksempel en mikrobryter i støtfangeren for å stanse bevegelse umiddelbart hvis et uventet objekt kommer i kontakt

- To fremadrettede 3D-kameraer med en rekkevidde på 4 m

- Nedadrettede sensor for å detektere kanten til en plattform (kalt klippedeteksjon)

- Kommunikasjonsmoduler som gir konnektivitet, og kan tilby valgfri Bluetooth-deteksjon av ankomstvinkel (AoA – Angle of Arrival) og utgangsvinkel (AoD – Angle of Departure) for sanntidslokaliseringstjenester (RTLS – real-time location services) eller 5G-sendepunkter/-mottakspunkter (TRP – Transmission Points/Reception Points) for å plotte et rutenett med nøyaktighet ned på centimeter-nivå

- 2D-LiDAR for å beregne nærheten av hindringer foran kjøretøyet

- 3D-dybdesynssystem med vidvinkel egnet for objektidentifikasjon og lokalisering

- Integrert databehandlingsprosessor med høy ytelse for sensorfusjon, AI og ML

Figur 1: Eksempel på AMR som viser mangfoldet og posisjonene til de integrerte sensorene. (Bildekilde: Qualcomm)

Figur 1: Eksempel på AMR som viser mangfoldet og posisjonene til de integrerte sensorene. (Bildekilde: Qualcomm)

Robotposisjon og sensorfusjon

AMR-navigasjon er en kompleks prosess. Et av de første trinnene er at AMR-en må vite hvor den er og hvilken retning den er vendt. Denne kombinasjonen av data kalles robotens posisjon (pose). Posisjon-konseptet kan også brukes på armene og endeeffektorene til fleraksede stasjonære roboter. Sensorfusjon kombinerer innganger fra IMU-en, kodere og andre sensorer for å fastsette posisjonen. Posisjon-algoritmen estimerer (x, y) posisjonen til roboten og orienteringsvinkelen θ, med hensyn til koordinataksene. Funksjonen q = (x, y, θ) definerer robotens posisjon. For AMR-er har informasjon om posisjon en rekke bruksområder, deriblant:

- Posisjonen til en inntrenger, for eksempel en person som trer inn i nærheten av roboten, i forhold til en ekstern referanseramme eller i forhold til roboten

- Den estimerte posisjonen til roboten etter å ha beveget seg i en gitt hastighet og i en forhåndsbestemt tidsperiode

- Beregne hastighetsprofilen som er nødvendig for at roboten skal bevege seg fra sin nåværende posisjon til en andre posisjon

Posisjon er en forhåndsdefinert funksjon i flere utviklingsmiljøer for robotprogramvare. For eksempel er pakken robot_pose_ekf inkludert i «Robot Operating System» (ROS), en utviklingsplattform med åpen kildekode. Robot_pose_ekf kan brukes til å estimere 3D-posisjonen til en robot basert på (delvise) posisjonsmålinger fra ulike sensorer. Den bruker et utvidet Kalman-filter med en 6D-modell (3D-posisjon og 3D-orientering) for å kombinere målinger fra koderen for hjulenes kilometertall (odometry), et kamera for visuelt kilometertall og IMU-en. Siden de forskjellige sensorene fungerer med forskjellige hastigheter og latenstider, krever ikke robot_pose_ekf at alle sensordataene skal være kontinuerlige eller parallelt tilgjengelige. Hver sensor brukes til å gi et posisjonsestimat med en kovarians. Robot_pose-ekf identifiserer tilgjengelig sensorinformasjon når som helst og justerer i samsvar med dette.

Sensorfusjon og SLAM

Mange miljøer hvor AMR-er er i drift, inkluderer variable hindringer som fra tid til annen kan bevege seg. Selv om et grunnleggende kart over anlegget er nyttig, er det behov for mer. Når AMR-er beveger deg rundt et i industrianlegg, trenger de mer enn posisjonsinformasjon; de benytter også SLAM for å sikre effektiv drift. SLAM legger til omgivelseskart i sanntid for å støtte navigasjon. To grunnleggende tilnærminger til SLAM er:

- Visuell SLAM som parrer et kamera med en IMU

- LiDAR SLAM som kombinerer en lasersensor som 2D- eller 3D-LiDAR med en IMU

LiDAR SLAM kan være mer nøyaktig enn visuell SLAM, men er som regel dyrere å implementere. Alternativt kan 5G brukes til å gi lokaliseringsinformasjon for å forbedre visuelle SLAM-estimater. Bruk av private 5G-nettverk i lagerhus og fabrikker kan utvide integrerte sensorer for SLAM. Noen AMR-er implementerer presis posisjonering innendørs ved hjelp av 5G-sendepunkter/-mottakspunkter (TRP) for å plotte et rutenett for nøyaktighet på x-, y- og z-aksene på centimeter-nivå.

Vellykket navigasjon er avhengig av en AMR og dens evner til å tilpasse seg skiftende elementer i omgivelsene. Navigasjon kombinerer visuell SLAM og/eller LiDAR SLAM, overleggsteknologier som 5G TRP og ML for å detektere endringer i omgivelsene og gi konstante plasseringsoppdateringer. Sensorfusjon støtter SLAM på flere måter:

- Kontinuerlige oppdateringer av den romlige og semantiske miljømodellen basert på input fra ulike sensorer som bruker AI og ML

- Identifisering av hindringer, slik at algoritmer for baneplanlegging kan foreta de nødvendige justeringene og finne den mest effektive banen gjennom omgivelsene

- Implementering av baneplanen, som krever sanntidsstyring for å endre den planlagte banen, inkludert hastigheten og retningen til AMR-en, etter hvert som omgivelsene endres

Når SLAM ikke er nok

SLAM er et viktig verktøy for effektiv AMR-navigasjon, men SLAM alene er utilstrekkelig. I likhet med posisjon-algoritmer, implementeres SLAM med et utvidet Kalman-filter som gir estimerte verdier. SLAM-estimerte verdier utvider posisjonsdataene, og legger til lineære hastigheter og rotasjonshastigheter, samt lineære akselerasjoner, med mer. SLAM-estimering er en totrinnsprosess. Det første trinnet innebærer å kompilere prediksjoner ved hjelp av intern sensoranalyse basert på fysiske bevegelseslover. Det gjenværende trinnet i SLAM-estimeringen trenger eksterne sensoravlesninger for å avgrense de innledende estimatene. Denne totrinnsprosessen bidrar til å eliminere og korrigere små feil som kan kompileres over tid og skape betydelige feil.

SLAM avhenger av tilgjengeligheten av sensorinnganger. I noen tilfeller kan det hende at relativt billig 2D-LiDAR ikke fungerer, for eksempel hvis det ikke er noen gjenstander i den direkte siktlinjen til sensoren. I slike tilfeller kan 3D-stereokameraer eller 3D-LiDAR forbedre systemytelsen. 3D-stereokameraer eller 3D-LiDAR er imidlertid dyrere og krever mer datakraft for å implementeres.

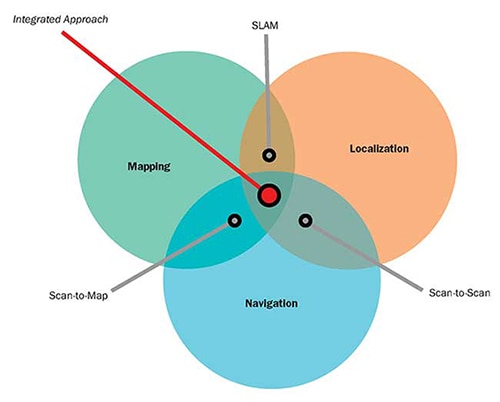

Et annet alternativ er å bruke et navigasjonssystem som integrerer SLAM med teknikker for skanning-til-kart-samsvaring og skanning-til-skanning-samsvaring, som kan implementeres ved å kun bruke 2D-LiDAR-sensorer (figur 2):

- Skanning-til-kart-samsvaring bruker LiDAR-områdedata til å estimere AMR-posisjonen ved å samsvare områdemålingene med et lagret kart. Effektiviteten til denne metoden avhenger av nøyaktigheten til kartet. Den opplever ikke vandring over tid, men i repeterende omgivelser kan den resultere i feil som er vanskelige å identifisere, forårsake diskontinuerlige endringer i oppfattet posisjon og være utfordrende å eliminere.

- Skanning-til-skanning-samsvaring bruker sekvensielle LiDAR-områdedata til å estimere posisjonen til en AMR mellom skanninger. Denne metoden gir oppdatert lokasjons- og posisjonsinformasjon (location and pose information) for AMR-en uavhengig av eksisterende kart, og kan være nyttig under oppretting av kart. Den er imidlertid en trinnvis algoritme som kan utsettes for vandring over tid uten mulighet til å identifisere unøyaktighetene som vandringen introduserer.

Figur 2: Algoritmer for skanning-til-kart-samsvaring og skanning-til-skanning-samsvaring kan brukes til å supplere og forbedre ytelsen til SLAM-systemer. (Bildekilde: Aethon)

Figur 2: Algoritmer for skanning-til-kart-samsvaring og skanning-til-skanning-samsvaring kan brukes til å supplere og forbedre ytelsen til SLAM-systemer. (Bildekilde: Aethon)

Sikkerhet trenger sensorfusjon

Sikkerhet er viktig for AGV-er og AMR-er, og flere standarder må tas i betraktning. For eksempel: American National Standards Institute / Industrial Truck Standards Development Foundation (ANSI/ITSDF) B56.5 – 2019, Sikkerhetsstandarder for førerløse, automatisk veiledede industrikjøretøy og automatiske funksjoner for industrikjøretøy med førere, ANSI / Robotic Industrial Association (RIA) R15.08-1-2020 – Standard for mobile industriroboter – Sikkerhetskrav, flere standarder fra International Standards Organization (ISO), med flere.

Sikker drift av AGV-er og AMR-er krever sensorfusjon, som kombinerer sikkerhetssertifiserte 2D-LiDAR-sensorer (noen ganger kalt sikkerhetslaserskannere) med kodere på hjulene. 2D-LiDAR støtter to deteksjonsavstander samtidig, kan ha en deteksjonsvinkel på 270 grader og koordinerer med kjøretøyhastigheten som rapporteres av koderne. Når et objekt detekteres i deteksjonssonen lengre borte (opptil 20 m unna, avhengig av sensoren), kan kjøretøyet bremses etter behov. Hvis objektet trer inn i den nærmere deteksjonssonen i kjørebanen, slutter kjøretøyet å bevege seg.

Sikkerhetslaserskannere brukes ofte i sett på 4, der en er plassert i hvert hjørne på kjøretøyet. De kan fungere som en enkel enhet og kommunisere direkte med sikkerhetsstyringen på kjøretøyet. Skannere er tilgjengelige og sertifiserte for bruk i sikkerhetskategori 3, ytelsesnivå d (PLd – Performance Level d) og sikkerhetsintegritetsnivå 2 (SIL2 – Safety Integrity Level 2), og de er plassert i et IP65-hus som er egnet for de fleste konstruksjoner utendørs og innendørs (figur 3). Skannerne inkluderer en inngang for trinnvis kodingsinformasjon fra hjulene for å støtte sensorfusjon.

Figur 3: 2D-lidarsensorer som dette kan kombineres med kodere på hjulene i et sensorfusjonssystem som gir sikker drift av AMR-er og AGV-er. (Bildekilde: Idec)

Figur 3: 2D-lidarsensorer som dette kan kombineres med kodere på hjulene i et sensorfusjonssystem som gir sikker drift av AMR-er og AGV-er. (Bildekilde: Idec)

Konklusjon

Intralogistikk støtter raskere og mer effektive forsyningskjeder i Industri 4.0-lager og -fabrikker. AMR-er og AGV-er er viktige verktøy for intralogistikk for å flytte materiale fra sted til sted på en betimelig og sikker måte. Sensorfusjon er nødvendig for å støtte AMR- og AGV-funksjoner, inkludert fastsettelse av posisjon, beregning av SLAM-data, forbedring av navigasjonsytelse ved hjelp av skanning-til-kart-samsvaring og skanning-til-skanning-samsvaring og sørge for sikkerhet for personell og gjenstander i hele anlegget.

Disclaimer: The opinions, beliefs, and viewpoints expressed by the various authors and/or forum participants on this website do not necessarily reflect the opinions, beliefs, and viewpoints of DigiKey or official policies of DigiKey.